삼성 vs 하이닉스, HBM3 기술력 비교

생활/업무 변화 요약

생활: 생성형 AI·번역·음성 비서가 더 빠르고 자연스러워집니다.

업무: 대규모 데이터 분석과 모델 학습·추론이 가속되어 프로젝트 리드타임이 단축됩니다.

산업: 메모리-대역폭 최적화가 서비스 설계의 핵심 변수로 부상합니다.

쉽게 알아보는 IT 용어

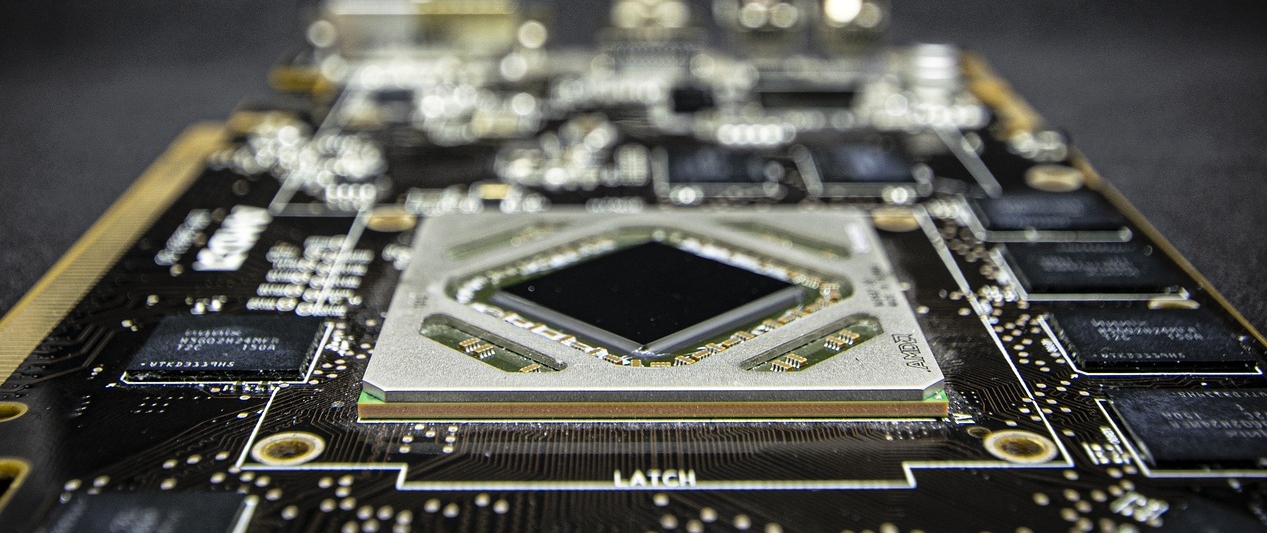

- HBM3: DRAM을 수직 적층하고 TSV로 연결해 스택당 최대 약 819GB/s(고속도로에 비유).

- TSV: 적층 칩 사이를 짧은 경로로 연결하는 실리콘 관통 전극.

- AI 가속기: GPU/TPU 등 AI 연산 특화 칩으로, HBM3와 결합해 성능을 극대화.

핵심 포인트(보강)

1) 삼성전자의 ‘안정성·효율’ 카드

삼성은 패키징·접합 기술을 고도화해 발열 특성 개선과 전력 효율을 강조합니다. 예컨대 TC-NCF 기반 미세 범프 설계로 신호/발열 영역을 구분해 접합 수율과 열 특성을 높였습니다. 데이터센터는 냉각·전력 비용이 직접 원가이므로, 이런 미세 개선이 TCO(총소유비용) 절감과 직결됩니다

2) SK하이닉스의 ‘성능·적층’ 카드

하이닉스는 업계 최초로 12-Hi(12단) HBM3를 공개·양산하며 고용량·고대역폭을 앞세웠습니다. 이는 동일 면적에서 더 많은 파라미터를 메모리에 상주시켜 학습/추론 시간을 실질적으로 단축합니다. 또 엔비디아향 HBM3 공급로 초기에 주도권을 잡으며 생태계 접점을 넓혔습니다.

3) ‘보이지 않는 심장’—서비스 품질을 좌우

HBM3는 모델 파라미터·KV 캐시 접근의 병목을 줄여 **지연(latency)·처리량(throughput)**을 동시에 개선합니다. 스택당 최대 819GB/s 대역폭 특성은 LLM·멀티모달 생성, 추천, 자율주행 학습 등에서 사용자의 체감 품질(응답 속도·정확도)에 직접 반영됩니다.

4) 기술 스펙을 넘어 ‘생태계’ 싸움

단순 속도/용량 우위만으로는 승부가 나지 않습니다. GPU 벤더·클라우드·서버 OEM과의 적기 검증(QA)·공급 안정성이 채택을 좌우합니다. 제 생각에는, 삼성은 ‘제조 신뢰성·전력 효율’을, 하이닉스는 ‘적층·대역폭·고객사 네트워크’를 무기로 HBM4 전환기에도 각자의 강점을 극대화하려 할 가능성이 큽니다. (관측 기반)

5) 사용자·기업에 미치는 실제 효과

- 사용자: 더 빠른 생성형 AI, 자연스러운 번역/요약, 안정적 스트리밍

- 기업: 모델 실험 주기가 단축되고, 같은 전력/랙 공간에서 더 많은 작업을 처리해 성능당 비용을 낮출 수 있습니다. 전력·냉각 최적화는 ESG 관점의 추가 이점입니다.

생각해볼 사항들

- 발열/전력 효율 vs 속도/용량—워크로드별 최적 조합은?

- GPU 벤더 자격·수율이 채택률에 미치는 영향은?

- HBM3E·HBM4 전환기에서 패키징(코워/인터포저)과 소프트웨어 스택은 어떻게 변할까?

- 국내 공급망(장비/소재) 협업의 경쟁력은?

- 모델 구조 변화가 HBM 수요 곡선에 미치는 영향은?

Q&A

Q1. 일반 소비자와 연관이 있나요?

직접 구매하진 않지만, 생성형 AI 속도·품질에서 체감됩니다.

Q2. 누가 '앞선'건가요?

용도·생태계에 따라 평가가 다릅니다. 하이닉스=적층/대역폭·엔비디아 협력, 삼성=발열·효율·제조 신뢰성이 강점입니다.

Q3. 다음 관전 포인트는?

HBM3E/4 전환, 패키징 공정, 전력·냉각 최적화, 주요 고객사의 검증·수요 계획입니다.

결론

HBM3 경쟁은 ‘스펙’ 너머 생태계·TCO 게임입니다. 삼성은 안정·효율, 하이닉스는 적층·대역폭과 고객 네트워크로 강점을 키우고 있으며, 최종 승부는 누가 더 빠르게 검증·공급 안정성을 증명하느냐에 달렸습니다.

3분 정리

- 무엇: 삼성 vs 하이닉스 HBM3 경쟁

- 왜: 연산 병목 해소로 모델 속도·품질·비용에 직결

- 누구: AI 기업·클라우드·엔터프라이즈·최종 사용자

- 언제/어디: 2025년 현재, 글로벌 데이터센터/엣지

- 지금 할 일: 대역폭/전력/수율 기준으로 인프라 로드맵 재점검