AI 경쟁의 무게중심이 ‘모델’에서 ‘인프라’로 옮겨가고 있습니다.

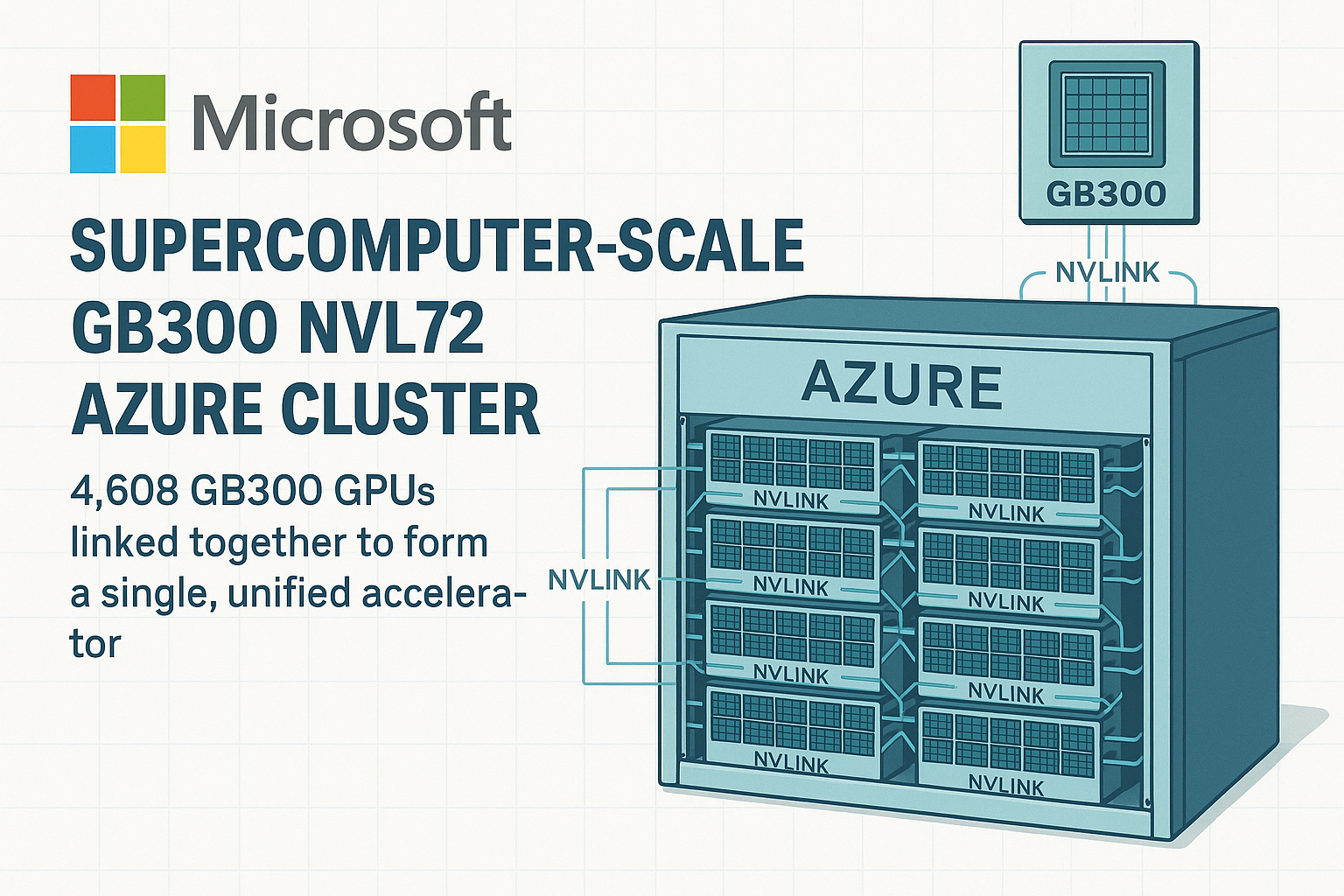

마이크로소프트가 세계 최초의 슈퍼컴퓨터급 AI 인프라, 즉 GB300 NVL72 GPU 4,608개를 묶은 단일 가속 클러스터를 Azure 데이터센터에 구축했다고 발표했습니다.

이 시스템은 **92.1 ExaFLOPS(초당 92경 회 연산)**의 FP4 추론 성능을 기록하며, 현재 상용화된 AI 연산 장비 중 가장 강력한 규모로 평가받고 있습니다.

“AI의 한계는 더 이상 알고리즘이 아니라, 하드웨어다.”

이번 클러스터는 엔비디아의 최신 GB300 GPU를 72개 단위로 묶은 NVL72 모듈 64세트를 고속 인터커넥트 NVLink로 연결한 형태입니다.

이렇게 구성된 클러스터는 GPU 간 메모리를 실시간 공유할 수 있어, 마치 하나의 거대한 그래픽 프로세서처럼 동작합니다.

마이크로소프트는 이번 프로젝트를 통해 “AI 모델이 하드웨어 제약 없이 학습·추론을 수행할 수 있는 환경”을 목표로 한다고 밝혔습니다.

이는 GPT-5, Claude 3.7, Gemini 2.5 등 차세대 초대형 언어모델(LLM)의 학습 효율성을 비약적으로 끌어올릴 수 있는 핵심 인프라로 주목받고 있습니다.

생활·업무 변화 요약

- AI 학습 효율의 재정의:

기존 대비 30~40% 빠른 모델 학습이 가능해집니다.

이는 ‘모델 업그레이드 주기’를 단축시켜, 더 자주·정확한 AI 서비스 제공이 가능함을 의미합니다. - 클라우드 서비스 강화:

Azure 클라우드 고객은 기존 대비 5배 빠른 AI 추론 속도를 체감할 수 있습니다.

고성능 모델을 빌려 쓰는 ‘AI as a Service’ 시장의 경쟁력이 급상승합니다. - 국가·기업 단위 AI 경쟁력 변화:

대형 모델 훈련을 위한 연산 인프라가 한정되어 있던 기존 환경이 완화되며,

연구기관이나 스타트업도 초대형 학습에 접근할 가능성이 열렸습니다.

쉽게 알아보는 IT 용어

ExaFLOPS (엑사플롭스)

초당 10¹⁸(1경) 회 연산을 처리하는 성능 단위.

92.1 ExaFLOPS는 인간 두뇌의 시냅스 계산량을 초과하는 수준으로, AI 추론용으로는 세계 최고 등급에 해당합니다.

NVLink / NVSwitch

엔비디아가 개발한 GPU 간 초고속 연결 기술.

CPU 대신 GPU들끼리 데이터를 직접 교환하여 대규모 병렬 연산에서 병목 현상을 제거합니다.

GB300 NVL72

엔비디아의 최신 서버용 AI 가속기.

FP4 연산(저정밀 추론)에 특화되어 있으며, 1개의 NVL72 모듈에는 72개의 GB300 GPU가 고속 네트워크로 통합되어 있습니다.

핵심 포인트

1. 4,608개 GPU가 ‘하나의 칩처럼’

마이크로소프트의 클러스터는 단순한 병렬 구조가 아닙니다.

GPU 간 메모리 풀링(memory pooling) 기술을 적용해 4,608개의 GPU가 마치 단일 거대 프로세서로 작동합니다.

이를 통해 초대형 LLM 학습 시 필요한 매개변수(파라미터) 전체를 한 번에 로드하고 처리할 수 있습니다.

2. FP4 연산의 실용화

FP4는 ‘4비트 부동소수점 연산’을 의미합니다.

정밀도는 낮지만 효율은 극대화되어,

AI 추론 시 전력 효율 2.5배, 처리량 3배를 달성할 수 있습니다.

92.1 ExaFLOPS는 이 FP4 기준 수치로, 실제 연산 효율 면에서도 기존 H100·H200 대비 1.8배 향상된 수준입니다.

3. Azure AI 인프라의 ‘하드웨어 독립성’

마이크로소프트는 이번 클러스터를 Azure 전용으로 구축하면서도,

엔비디아·AMD·인텔·Tenstorrent 등 다양한 칩을 지원하는 멀티 벤더 전략을 병행하고 있습니다.

이는 특정 GPU에 의존하지 않고 “모델이 곧 플랫폼”이 되는 구조를 의미합니다.

4. 경쟁사 비교 — 구글·AWS

| 항목 | 마이크로소프트 (Azure GB300) | 구글 (TPUv5e) | AWS (Trainium2) |

| 연산 성능 | 92.1 ExaFLOPS (FP4) | 45 ExaFLOPS (BF16) | 약 60 ExaFLOPS (BF16) |

| GPU 수 | 4,608 (GB300) | 약 2,000 TPUv5e | 약 3,500 Trainium2 |

| 구조 | NVLink + NVSwitch 통합 | TPU Pod | Nitro Fabric |

| 강점 | 범용·확장성 | 최적화된 내부용 | AI 전용 클라우드 |

AI 인프라 경쟁의 판도는 이제 **‘가속기 아키텍처 전쟁’**으로 확장되고 있습니다.

5. 지속 가능한 AI를 향한 전환

이번 클러스터는 재생에너지 기반 냉각 시스템을 채택해 전력 사용량 대비 연산 효율(Perf/Watt)을 45% 개선했습니다.

AI 모델 학습의 전력 소모 문제가 심화되는 상황에서, 이는 ESG(환경·사회·지배구조) 관점에서도 의미 있는 진전으로 평가됩니다.

Mini Q&A

Q1. 92.1 ExaFLOPS면 GPT-5 같은 모델도 충분히 학습 가능한가요?

→ 예. GPT-5 규모(약 2.2조 파라미터)의 모델도 병렬 학습이 가능하며, 추론 단계에서는 최대 10개 모델을 동시에 처리할 수 있습니다.

Q2. Azure 고객이 이 시스템을 바로 이용할 수 있나요?

→ 2025년 4분기부터 Azure AI Supercomputing 인스턴스로 순차 개방 예정입니다.

Q3. 엔비디아 독점인가요?

→ 현재는 GB300 중심이지만, AMD MI400 시리즈를 통합하는 멀티 구조가 논의 중입니다.

Q4. 실제 상용화 의미는?

→ 초거대 AI 모델 학습 주기 단축 → AI 서비스 출시 속도 가속 → 기업 경쟁력 강화.

“AI 경쟁의 최전선은 이제 데이터센터 안의 배선과 냉각관에서 벌어지고 있다.”

결론

마이크로소프트의 GB300 NVL72 슈퍼컴퓨터급 클러스터는 단순한 ‘GPU 집합체’가 아니라, AI 연산의 새로운 단위 개념을 제시한 사건입니다.

AI 모델이 한계를 맞는 시대에, MS는 하드웨어·전력·클라우드 삼각 축을 통합해 “AI를 위한 운영체제(OS)”를 만들고 있습니다.

이번 발표는 AI 인프라 시장이 “더 강한 모델”이 아닌 **“더 큰 연산 공간”**으로 이동했음을 보여줍니다.

3분 정리

- 마이크로소프트, GB300 NVL72 GPU 4,608개 연결한 세계 최초 슈퍼컴퓨터급 AI 클러스터 공개

- FP4 연산 기준 92.1 ExaFLOPS, 현존 최고 추론 성능

- NVLink·NVSwitch로 GPU 메모리 통합, 단일 가속기처럼 작동

- Azure AI 클라우드 성능 5배 향상, 2025년 내 상용화 예정

- 구글·AWS 대비 확장성과 전력 효율에서 우위 확보

출처

- Tom’s Hardware — Microsoft deploys world’s first ‘supercomputer-scale’ GB300 NVL72 Azure cluster (2025-10-09)

- Microsoft Azure Blog — Building next-gen AI infrastructure for GPT-scale workloads (2025-10 확인)

- NVIDIA GB300 Architecture Whitepaper (2025 Q3 공개)